La noticia suena muy técnica, pero tiene mucha más miga de la que parece. Un equipo de Google Quantum AI ha demostrado por primera vez que una memoria cuántica comete menos errores cuando se le añaden más cúbits, en lugar de volverse más inestable. Es lo que en física se llama superar el “umbral de corrección de errores” y es una pieza básica para que algún día los ordenadores cuánticos puedan ayudar en tareas como optimizar redes eléctricas llenas de renovables o mejorar los modelos de clima que usamos para prever olas de calor e inundaciones.

Qué han conseguido exactamente

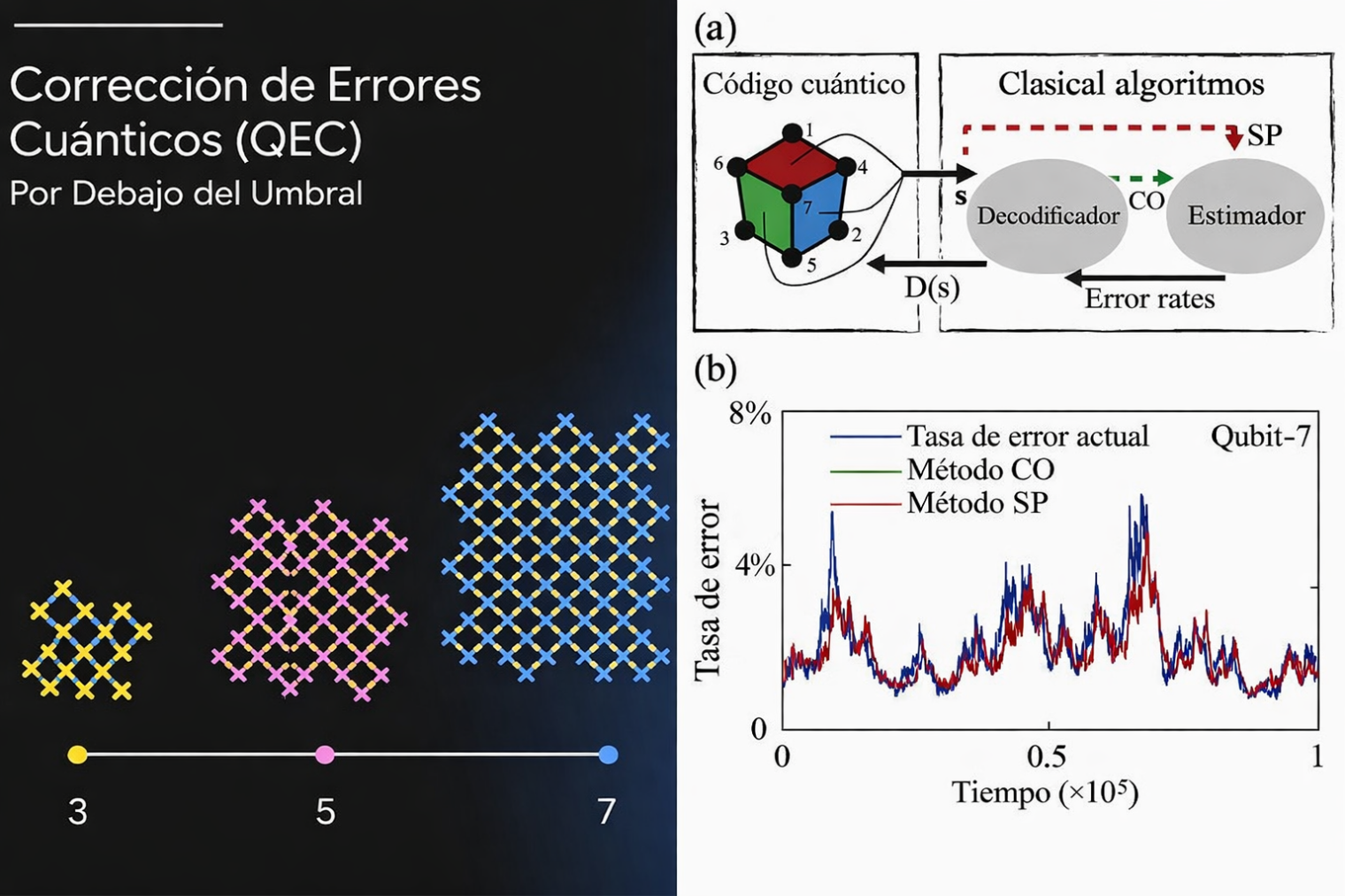

Hasta ahora, los ordenadores cuánticos eran brillantes sobre el papel, pero muy frágiles en la práctica. Cada cúbit es extremadamente sensible al ruido del entorno. El truco de la corrección cuántica de errores consiste en agrupar muchos cúbits físicos para formar un solo “cúbit lógico” más robusto, un poco como cuando varias voces cantan al unísono y tapan los fallos individuales.

El problema es que esa estrategia solo funciona si los cúbits físicos ya son lo bastante buenos. Si la tasa de error está por encima de cierto umbral, añadir más cúbits solo multiplica los problemas. Si está por debajo, entonces cada vez que ampliamos el código la probabilidad de fallo del cúbit lógico cae de forma drástica.

En el nuevo trabajo, el equipo de Google ha implementado un código de “superficie” sobre sus chips Willow y ha construido memorias cuánticas de distinta “distancia”, es decir, utilizando más o menos cúbits para proteger la misma información. Cuando pasan de un código de distancia 3 a otro de distancia 5 y después a distancia 7, la tasa de error lógica se reduce aproximadamente a la mitad en cada salto.

El resultado más llamativo es un código de distancia 7 que usa 101 cúbits físicos y alcanza una tasa de error de alrededor del 0,143 por ciento por ciclo de corrección, con una memoria lógica que vive más del doble que su mejor cúbit individual. (arxiv.org) En palabras del físico Michael Newman, investigador de Google Quantum AI, “hay una diferencia entre creer en algo y verlo funcionar”.

Y todo esto, ¿qué tiene que ver con el medio ambiente?

La conexión no es inmediata, pero sí real. Muchos de los grandes retos climáticos y energéticos se reducen a problemas de cálculo gigantescos. Modelar la atmósfera y los océanos en alta resolución, ajustar miles de parámetros de un modelo de clima o decidir en cada momento cómo repartir la electricidad de la red para encajar la solar y la eólica sin apagones exige una potencia de cálculo enorme y cada vez más costosa en energía.

Varios grupos de investigación señalan que los ordenadores cuánticos podrían acelerar en el futuro el corazón matemático de los modelos climáticos, resolviendo ecuaciones diferenciales complejas o afinando más rápido los modelos híbridos que combinan física y aprendizaje automático.

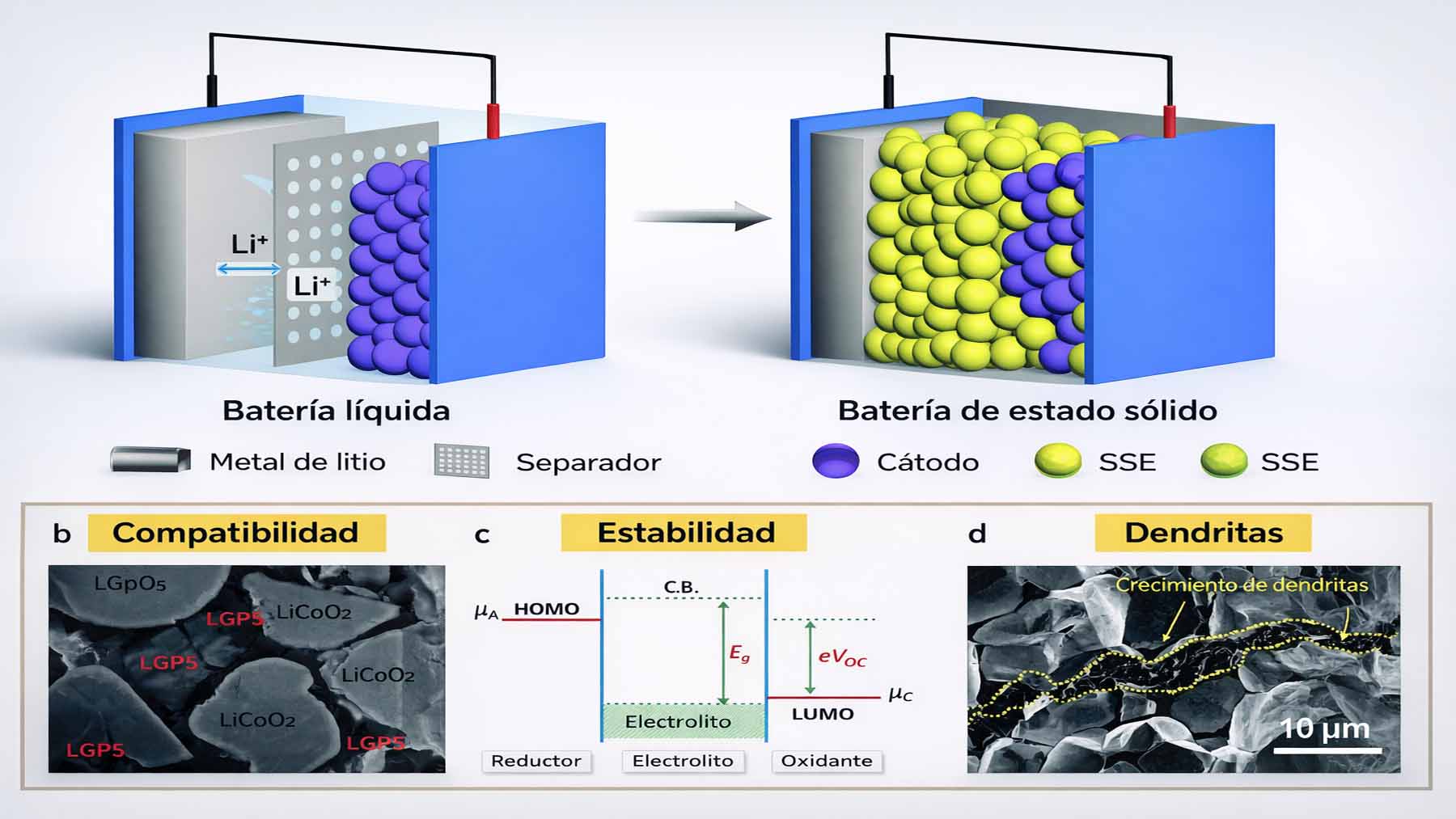

En paralelo, actores del sector energético ya exploran algoritmos cuánticos para prever mejor la producción renovable, optimizar el uso de baterías y planificar el flujo de electricidad en redes mucho más variables, con millones de placas solares y coches eléctricos enchufados a la vez.(weforum.org) En teoría, resolver mejor esos puzles podría traducirse en menos energía desperdiciada, menos centrales de respaldo fósiles encendidas y, con el tiempo, menos emisiones. En el fondo, lo que se busca es que la planificación de la red vaya tan fina como para que esa factura de la luz tan volátil se vuelva algo más predecible.

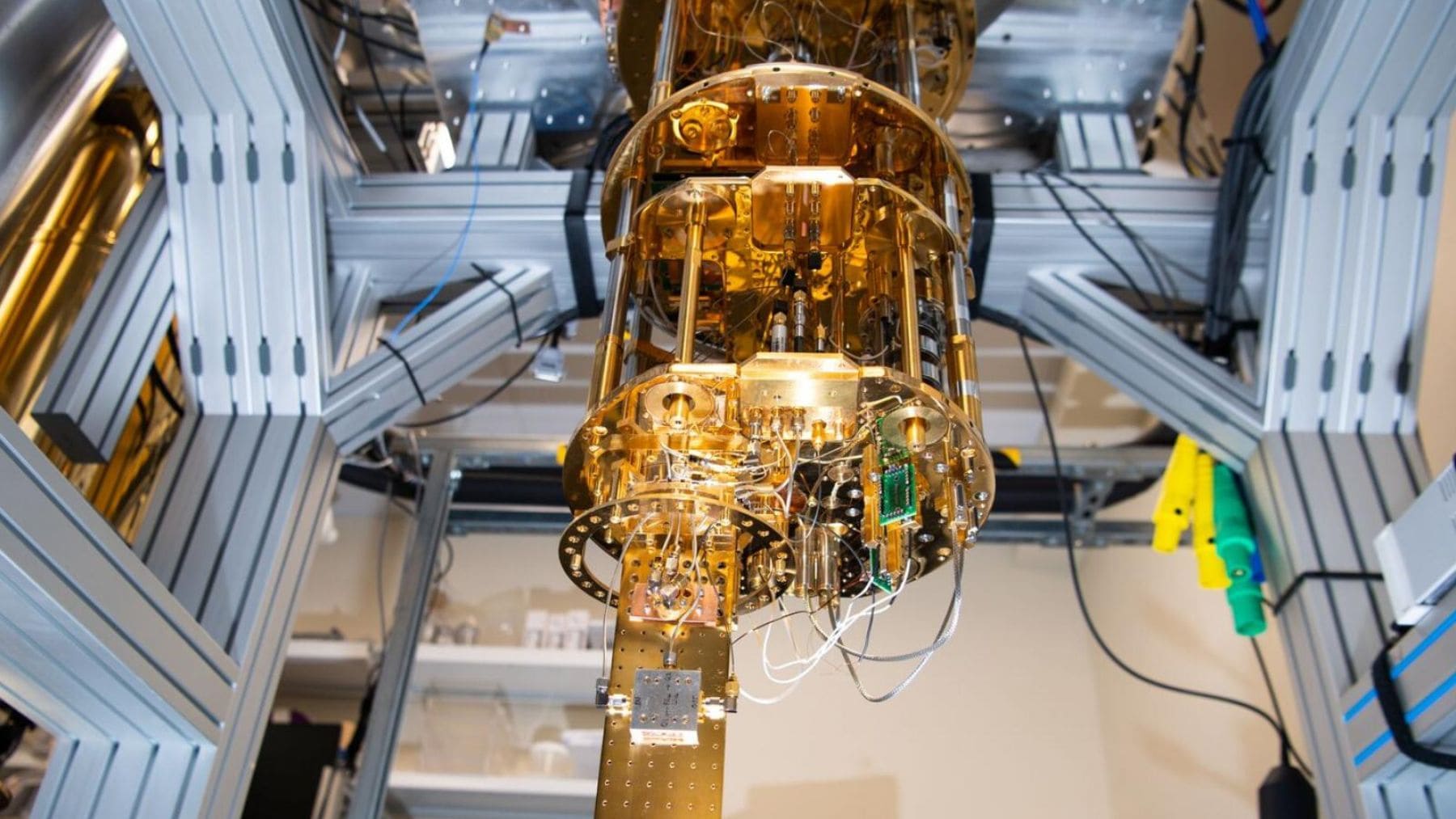

También hay un debate abierto sobre el propio impacto ambiental de estos sistemas. Los ordenadores cuánticos actuales necesitan refrigeración criogénica extrema y salas de control muy especializadas. Sin embargo, algunos análisis apuntan a que, para ciertos cálculos muy pesados, un ordenador cuántico maduro podría consumir mucha menos energía que un superordenador clásico que hace el mismo trabajo. (sciencedirect.com) El equilibrio final dependerá de cómo evolucione tanto el hardware cuántico como la eficiencia de los centros de datos donde se alojan.

Lo que aún no va a cambiar mañana

Conviene poner los pies en la tierra. El experimento de Google trabaja con uno solo cúbit lógico bien protegido. Para abordar problemas relevantes en clima, química de materiales o gestión de grandes redes eléctricas harían falta miles de cúbits lógicos, es decir, más de un millón de cúbits físicos de alta calidad, junto con sistemas de corrección de errores y decodificación en tiempo real mucho más potentes que los actuales.

En otras palabras, este resultado no va a reducir de golpe las emisiones ni a abaratar de inmediato la energía renovable. Los propios autores del estudio admiten que quedan desafíos importantes, desde el consumo energético de la infraestructura hasta la vulnerabilidad a fallos raros pero devastadores que aparecen cada cierto tiempo.

Lo que sí cambia es el nivel de confianza. Varios expertos que llevaban años trabajando en corrección de errores cuánticos reconocen que no esperaban ver tan pronto una demostración clara de que aumentar la escala mejora de verdad el comportamiento del sistema (quantamagazine.org) A partir de aquí, cada mejora incremental en los cúbits físicos se traducirá en errores lógicos mucho más bajos, algo esencial si algún día queremos que estos ordenadores se usen para tareas climáticas críticas en lugar de quedarse en curiosidades de laboratorio.

Para quien mira el problema del clima desde la urgencia, puede parecer un avance demasiado abstracto. Sin embargo, los modelos de clima más finos, las redes eléctricas capaces de integrar más renovables sin sobresaltos y el diseño de nuevos materiales para baterías más sostenibles necesitan herramientas computacionales que hoy están al límite de lo que pueden hacer los superordenadores clásicos. Este salto en corrección de errores no resuelve el problema, pero pone una pieza clave en su sitio.

El estudio oficial Quantum error correction below the surface code threshold ha sido publicado en la revista Nature.