ChatGPT: consumo desorbitado de energía y agua, su coste ambiental no tiene nada de inteligente: generar un texto de 100 palabras en ChatGPT consume, en promedio, 519 mililitros de agua, el equivalente a una botella del líquido. ¿Qué precio paga el planeta por cada palabra generada por la Inteligencia Artificial?

Este es el interrogante que surge al desvelar las cifras alarmantes de recursos necesarios para mantener en funcionamiento los modelos avanzados de inteligencia artificial como ChatGPT.

Detrás de cada interacción aparentemente trivial con un chatbot, se esconde un sistema complejo y voraz, cuya operación deja una marca significativa en el medio ambiente.

Desde su lanzamiento en 2022, ChatGPT ha sido utilizado por aproximadamente el 25% de los estadounidenses, según cifras del Pew Research Center. Sin embargo, estas interacciones cotidianas vienen acompañadas de un consumo desproporcionado de agua y electricidad, generando preguntas cruciales sobre su sostenibilidad.

Cada palabra tiene un coste energético real

Una simple frase de cortesía a ChatGPT puede parecer inocente, pero cada palabra tiene un coste energético real. Energía, agua y millones de usuarios diarios: el coste ambiental oculto de la inteligencia artificial.

Saludar a ChatGPT con un «Hola, ¿cómo estás?» y recibir su respuesta amistosa («¡Hola! Muy bien, gracias por preguntar. 😊 ¿Y tú? ¿Cómo estás? ¿En qué te puedo ayudar hoy?») supone un consumo energético, según me cuenta ChatGPT, similar a tener una bombilla led de 10 vatios encendida durante 72 segundos.

Aunque puede parecer un gasto mínimo, si se multiplica este consumo por los 122 millones de usuarios activos diarios que tiene de media ChatGPT en todo el mundo (sin contar otras herramientas de inteligencia artificial disponibles), el gasto es inmenso.

Cada palabra que me envías contribuye un poco al consumo energético, aunque solo sea para decir ‘hola’, ‘adiós’ o ‘gracias‘, me comenta ChatGPT.

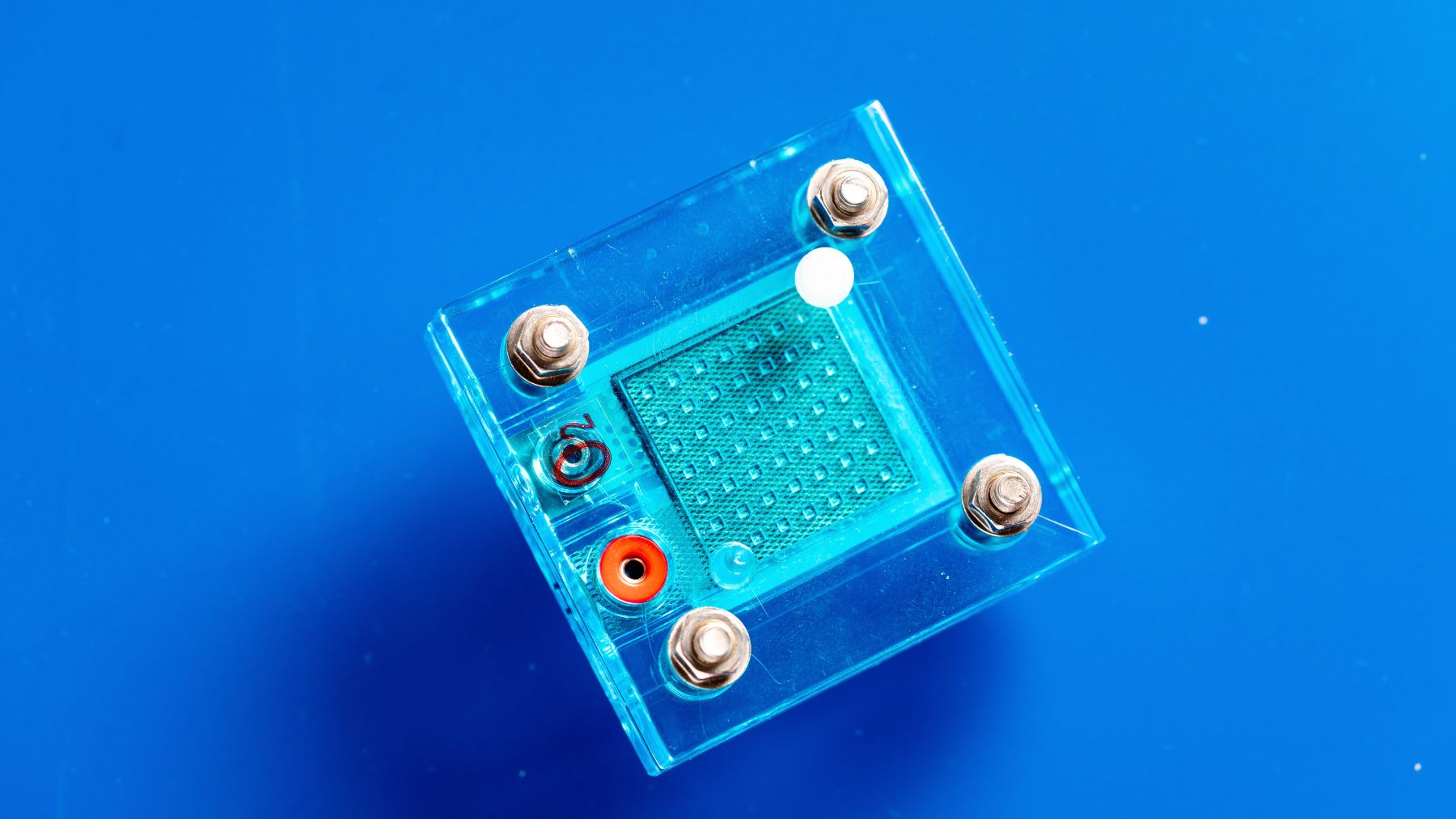

El consumo energético de una IA se reparte en dos grandes momentos: el entrenamiento del modelo y su uso o explotación», explican. En este primer estadio, el entrenamiento es lo más costoso.

Cada petición activa millones de cálculos para generar una respuesta nueva desde cero

Requiere semanas o meses de cálculo intensivo en centros de datos donde miles de unidades de procesamiento gráfico (GPU) trabajan en paralelo para analizar y aprender de billones de palabras y datos.

Este proceso se hace una sola vez (o pocas veces, si se reentrena), pero su huella energética es enorme y tiene lugar en los centros de datos y procesado», detallan.

La segunda parte es lo que hacemos los humanos con esta herramienta: las preguntas y consultas que le enviamos una vez que el modelo ya está entrenado y disponible para ser usado.

Es mucho menos costoso, aunque sigue siendo considerable si lo comparamos con servicios más simples, como el correo electrónico. Incluso en esta fase de explotación, cada petición activa millones de cálculos para generar una respuesta nueva desde cero, añaden.

¿Qué supone para el planeta una conversación? ¿Y una imagen?

Si solo chateamos o me pides texto, soy relativamente eficiente; si me pides imágenes artísticas, gráficos pesados o vídeos generados con IA, esto sube mucho la potencia necesaria», me explica ChatGPT sobre cuáles son las peticiones que más energía le suponen.

Y advierten: Si alguna vez tienes acceso a entrenar modelos desde cero (como los investigadores), estás entrando en el terreno más energívoro de todos.